文/康永红

整理/LiveVideoStack

今天分享的主题是华为云媒体质量管理最新实践成果,“视镜”是华为云研发的与媒体服务相关的质量管理平台。

分享的内容主要包括三部分:

第二部分针对媒体质量的新需求与挑战,华为云的解决之道;

第三部分华为云针对媒体质量做了哪些实践。

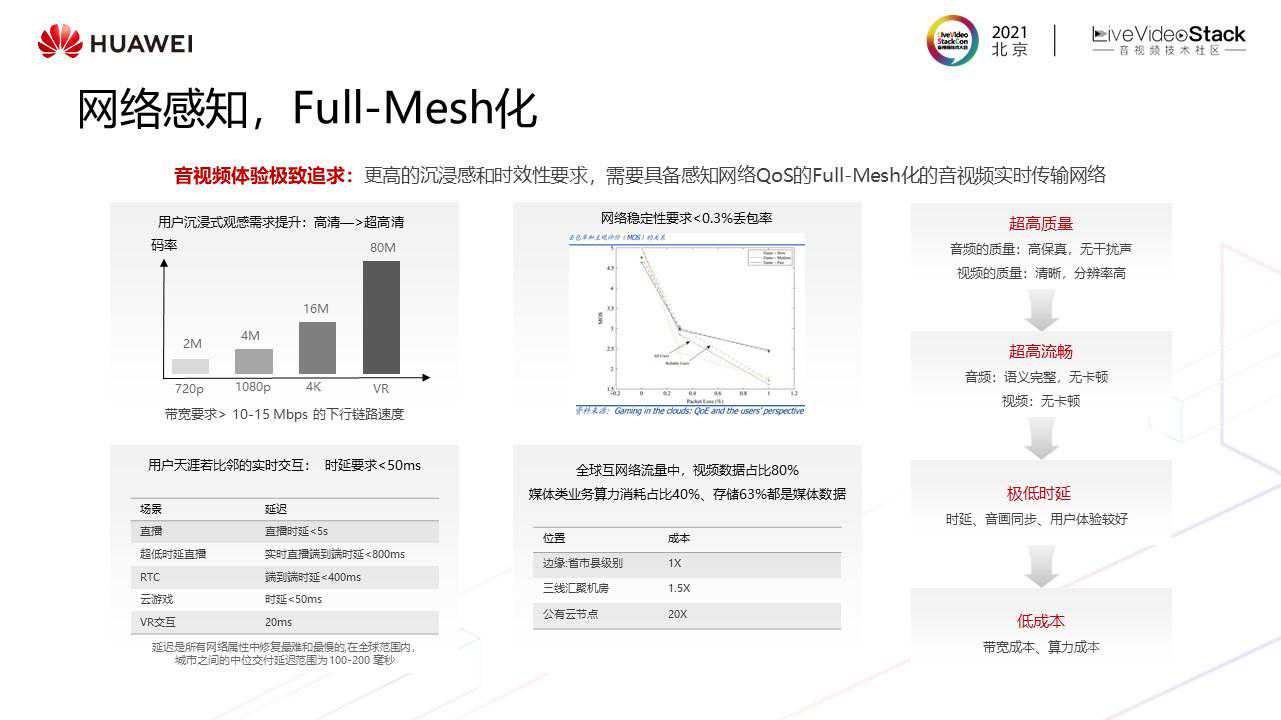

媒体质量新需求与新挑战

用户体验优化手段少,目前主要是局部调优或人工调优,效率较低,效果较差;

成本优化难:多样性体验成本诉求以及资源建设周期成本都需要优化;

查问题定位难,运维效率低。

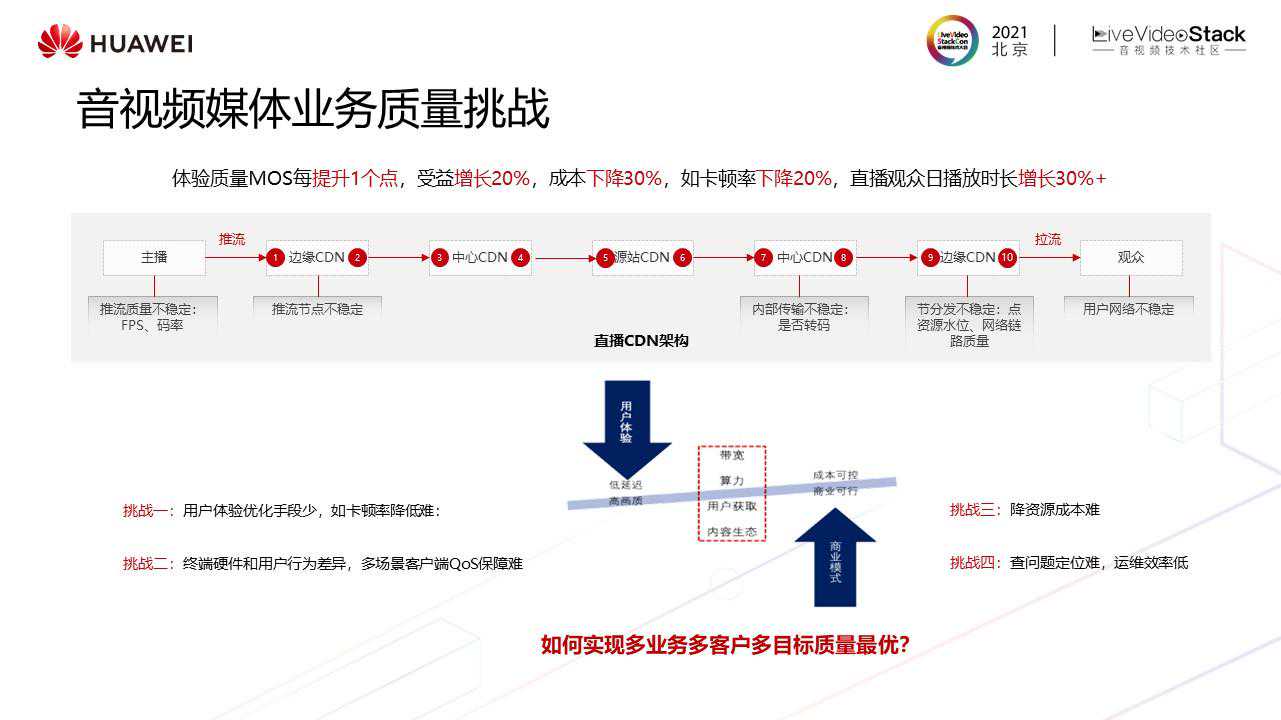

以上四个挑战可以综合为一个问题:如何实现多业务多客户多目标质量最优?

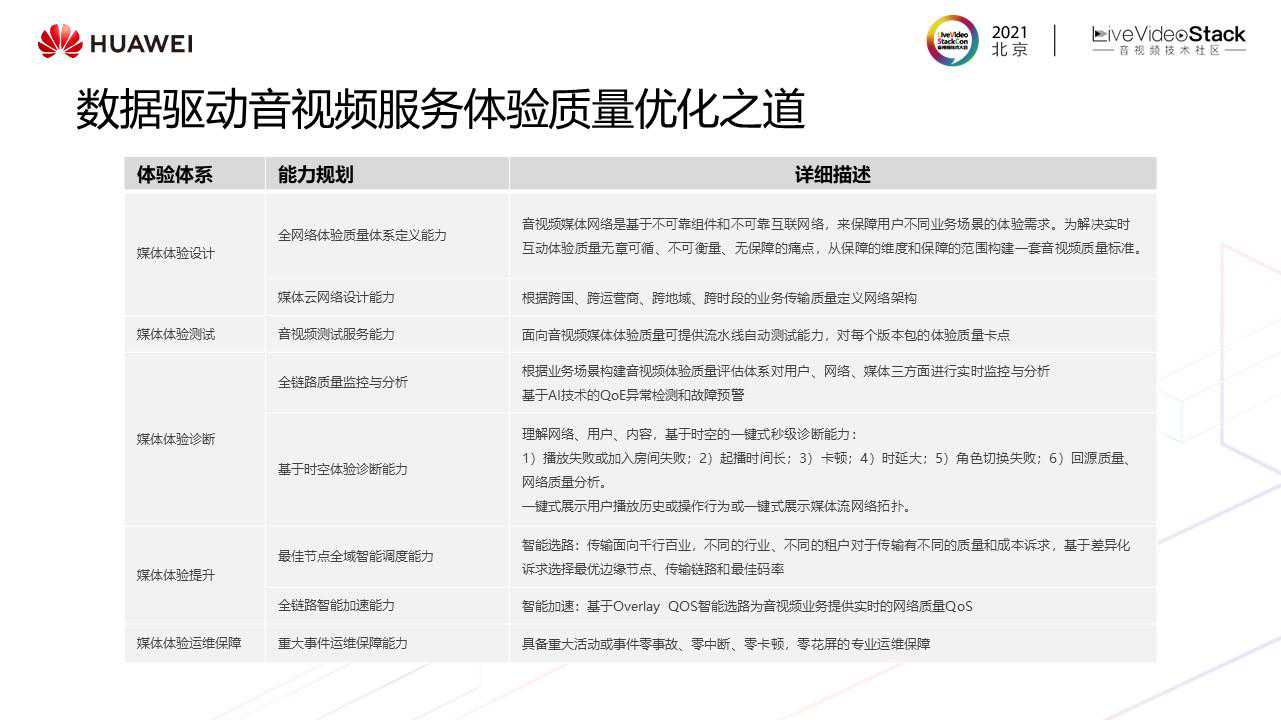

如何做到多业务多客户多目标的综合质量最优,接来下从体系和能力建设视角分享下我们的优化之道。去年也做了关于体验优化这个问题的分享,但当时只分享了两部分,体验诊断及体验提升。但在实际业务中,这两点根本无法达到预期。

接来下分别针对各个环节分享华为云的实践。

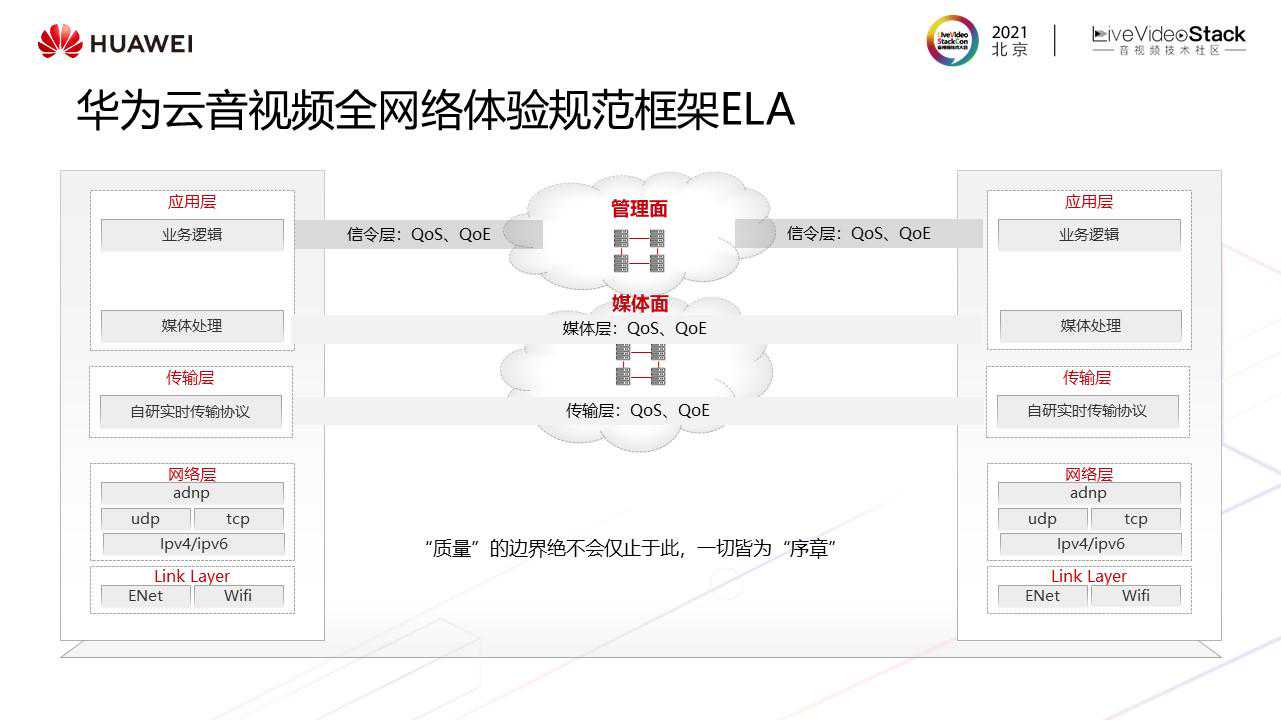

我们认为“质量”的边界绝不会仅止于此,一切皆为“序章”。

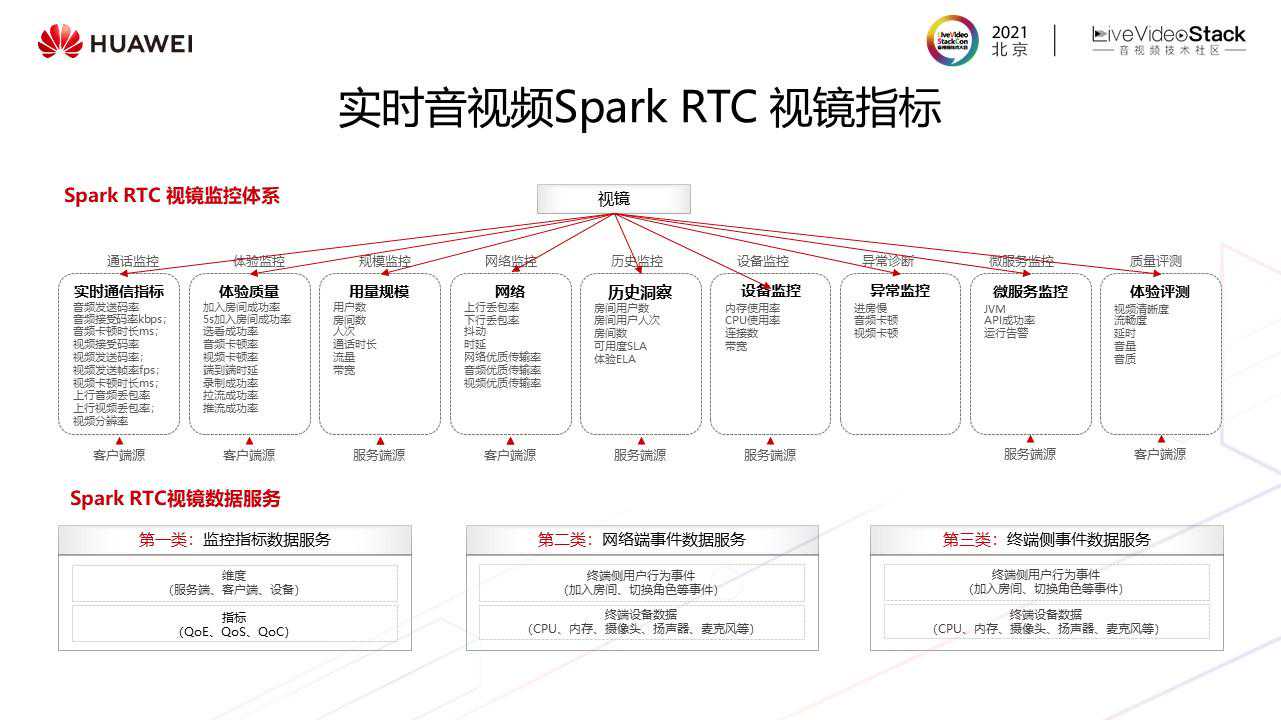

视镜服务依赖于网络和端的监控数据,由用户行为数据、网络传输面及媒体面数据等综合分析计算而成。

下面针对这6个核心能力展开介绍我们做的一些实践。

华为云媒体质量优化实践

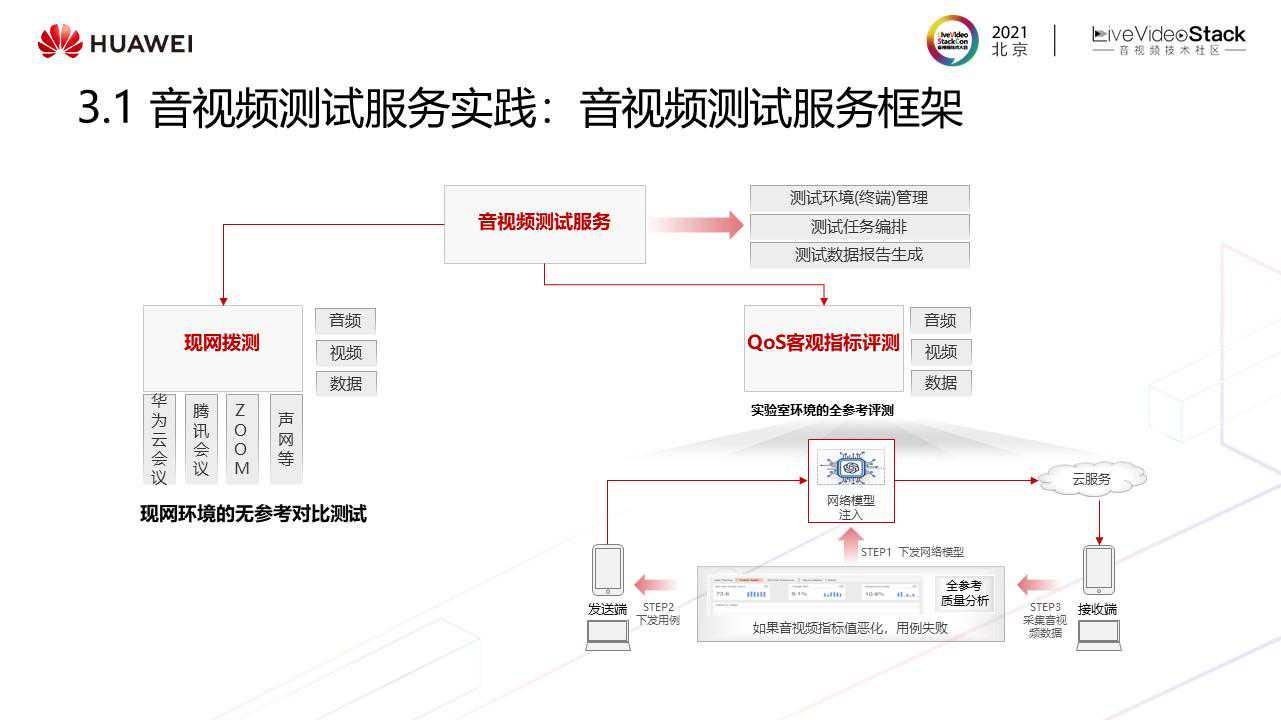

现网环境的无参考自动对比测试,替换传统的手工拨测方式,提高拨测效率;

实验室环境的体验全参考评测,基于网络模型+全参考,全覆盖测试现网真实场景的体验质量,解决路测的短板,因为路测无法覆盖测试现网所有的网络弱网场景,而有了全参考的环境评测机制,基本能够模拟现网90%的场景,而且全参考测试出的质量更接近用户主观感受。

在测试流程中,我们针对两个短板设计了解决方案。

产品上线,进入运维周期,首先要具备全链路质量监控与分析,对于了解网络状况、体验优化、容量规划、故障排除等十分重要。全链路检测和分析面临着四方面挑战:准确性(监控指标是否完整,定义指标是否合理)、可扩展性(对于监控上千个节点的大容量网络时,需要具备实时伸缩性)、速度(达到实时监控)、完备性(监控需要覆盖端到端,从推流到拉流)。

我们设计了三条优化实践之路:

基于“人、站、流”三维度空间实时监控百万级对象各项指标,将系统分为人、站、流后基本能够详细定义指标;

基于端(一方端+三方端)和网络数据进行全链路的网络实时监控与分析,解决完备性问题。下面2个案例分别是直播业务和SparkRTC二个业务的全链路监控和分析,直播全链路分析场景下,端的数据是结合客户的三方端数据和我们的一方端网络数据构建而来,可以监控从主播到观众到网络的整个链路。

右侧的SparkRTC是基于一方端的数据和一方网络数据做的全链路网络质量监控,每个节点的QoE、QoS指标都可以进行对比,还可以分析用户操作,监控网络的质量。

下面我们从监控的三个维度,用户、站、流分析打开看一些具体实践。

首先是用户体验监控和分析。

其次从网络质量监控分享一些实践。

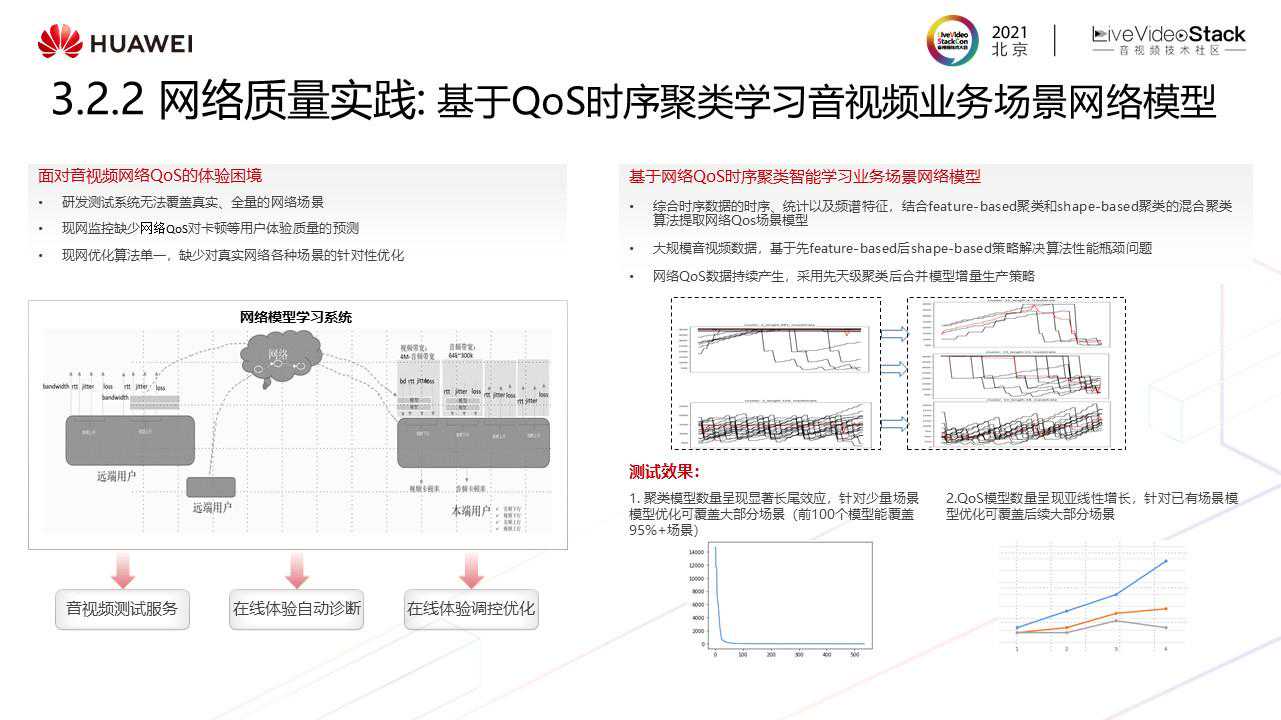

研发测试基本是路测,带着手机去地铁站、机场等场所,无法覆盖真实、全量的网络场景;

现网监控缺少基于网络QoS对卡顿等用户体验质量的预测;

现网会针对弱网、编解码做优化算法,但目前优化算法较单一,缺少对真实网络各种场景的针对性优化。

技术上采用基于网络QoS时序聚类智能学习业务场景网络模型,先时序特征聚类,后形状聚类。这里面临的两个挑战,1、每天需要学习现网几十甚至上百T的QoS数据,通过结合特征聚类和形状聚类的方式能够解决此问题。2、每天要学习现网前一天的全量模型,这里有一个增量策略。

从实际使用情况来看,有以下两个观点适用于所有业务:

聚类模型数量呈现显著长尾效应,针对少量场景模型优化可覆盖大部分场景(前100个模型能覆盖95%+场景);

QoS模型数量呈现亚线性增长,不会新增过多模型,针对已有场景模型优化可覆盖后续大部分场景。

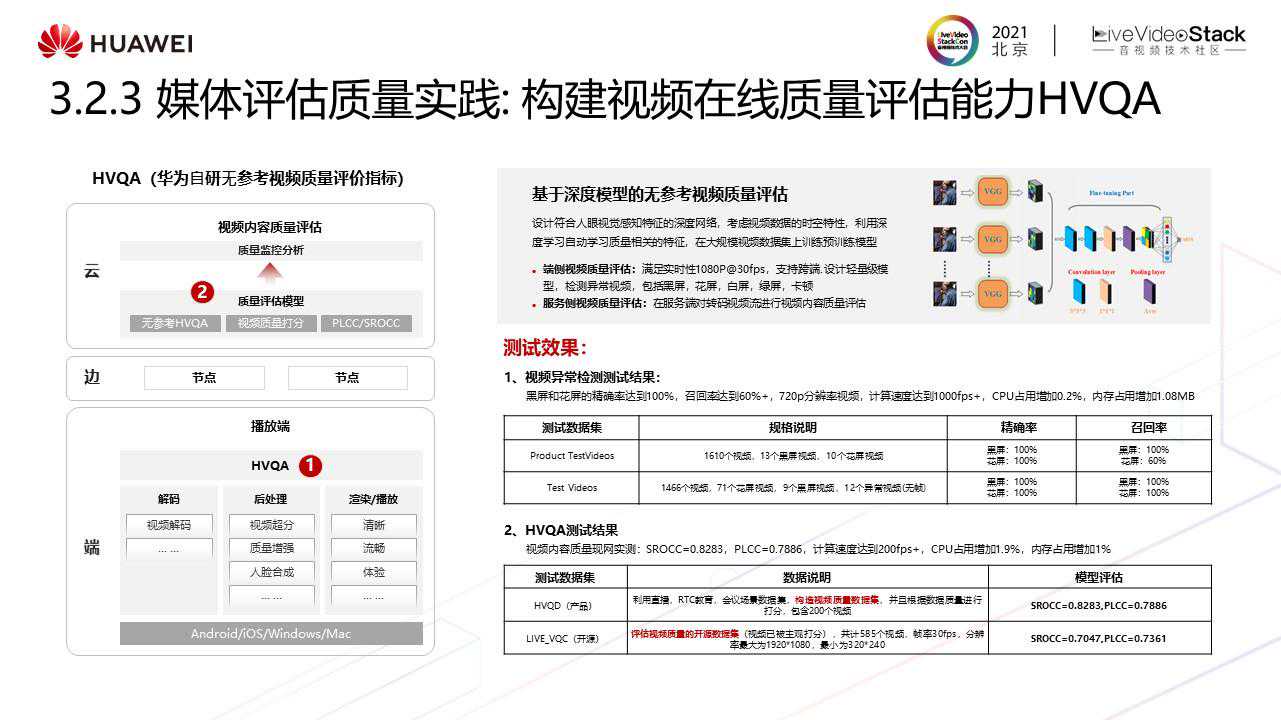

最后是媒体流内容质量评估的实践。

编码优化,评估、优化编码器质量;

质量提升,前处理、后处理、画质增强对清晰度的影响;

成本优化,调节最优的清晰度、节省码率以及带宽成本。

构建自动化极致体验优化系统,提升终端用户体验。

目前华为云的会议系统已在逐步应用HVQA。

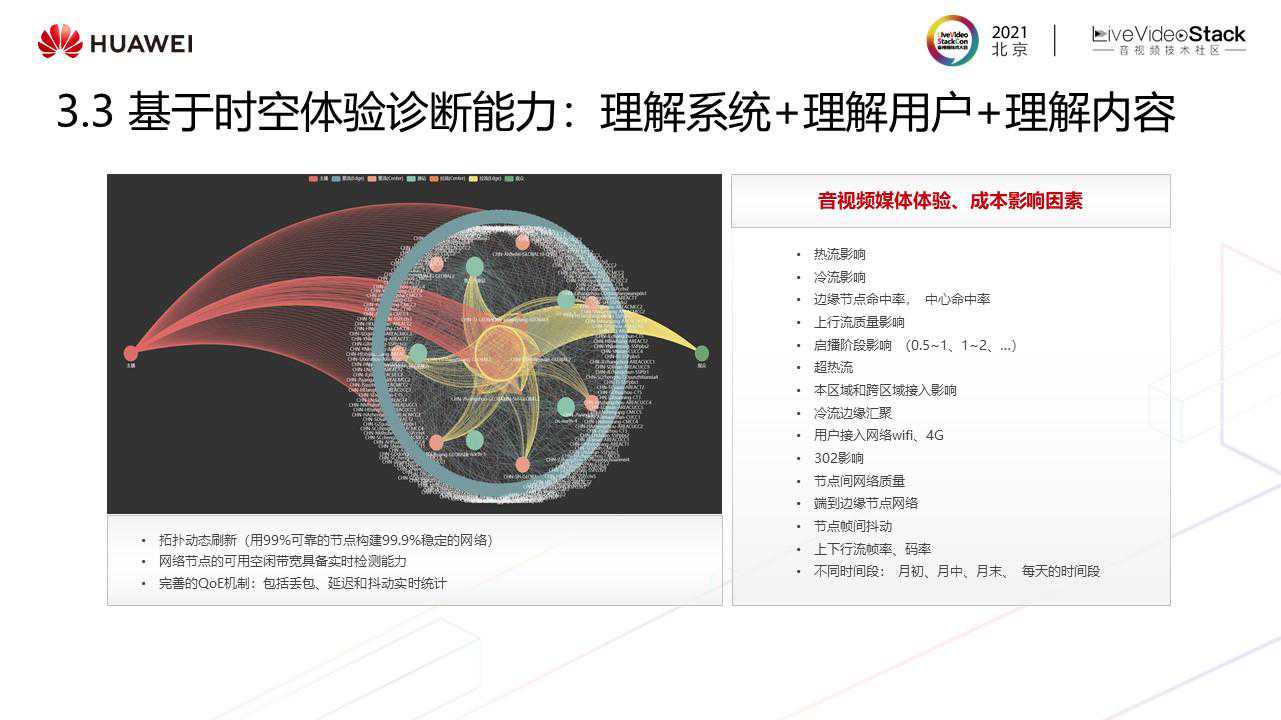

数字世界中已有百万级对象、千万级关系、亿级时序线。

诊断模型的构建策略是分三层来构建整体的能力,最基础的能力就是构建L0全链路网络拓扑基础能力,其次是基于L0能力构建基于时空质量因素自动诊断全网体验问题,最上层是业务分析能力层,支撑体验指标与业务规模的多维分析,如果上层业务体验指标发生了变化,通过业务模型、诊断能力,全链路能够快速找到影响因素并进行优化。

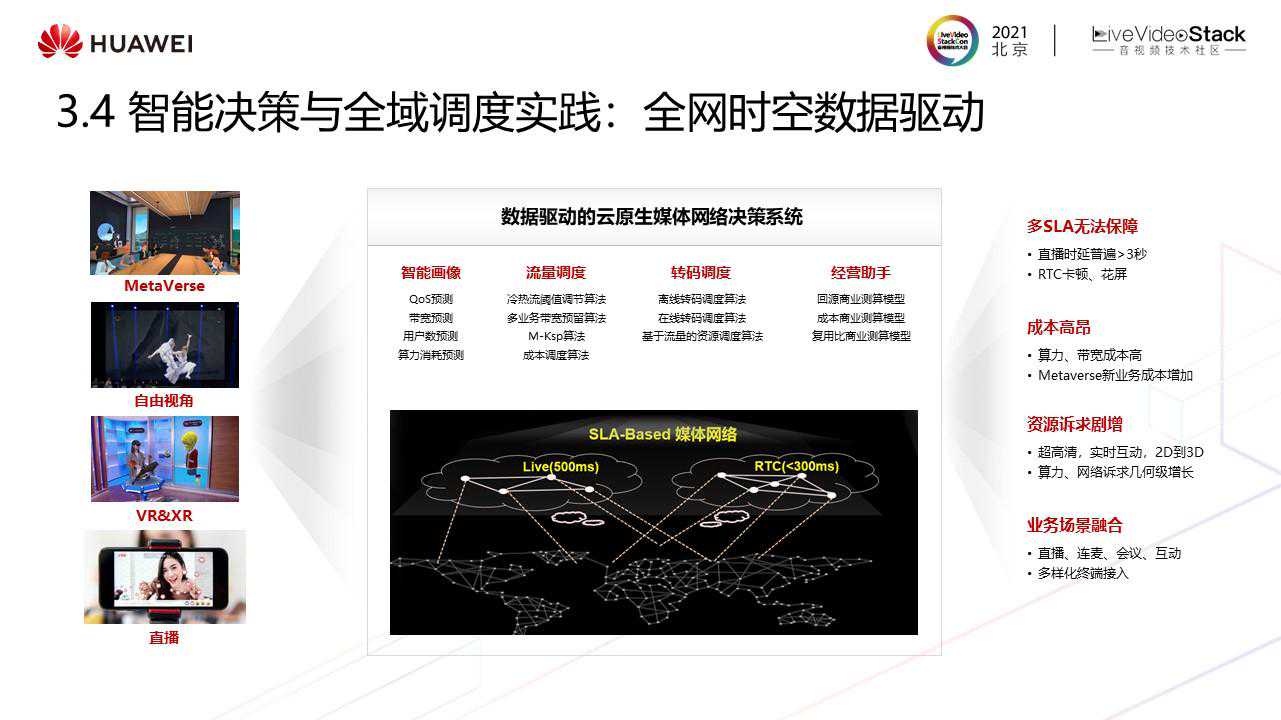

接下来介绍在体验提升方面的一些实践,实践包括业务层的全域调度及传输层的全链路加速。现网存在的很多问题是无法使用单一方法解决,这里有四个问题:多SLA保障问题,成本高昂问题、资源诉求剧增、业务场景融合,这些问题往往都是多业务,多目标的综合性问题,需要一个数据驱动的云原生媒体网络决策系统来解决,决策系统需要具备的核心能力是智能画像(能够进行QoS预测、带宽预测、用户数预测、算力消耗预测),流量调度、算力调度、商业助手(因为所有业务都跑在一张网络上,涉及到资源复用,需要知道下一位用户第二天的复用情况。需要从回源率、成本、复用比三个维度进行预测)。

通过多目标、多业务的调度技术实践,在回源率降低20%的情况下,首帧时延还能优化8%,转码算力成本降低50%。

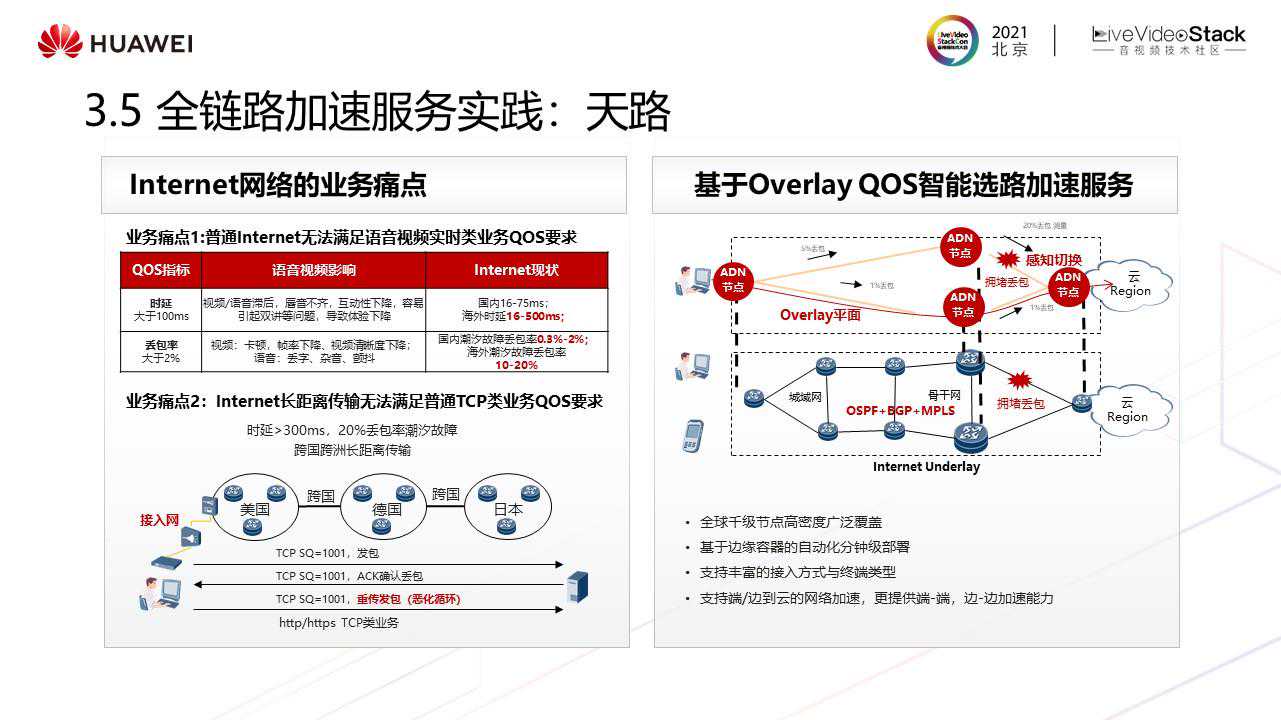

下面分享传输层全链路加速服务。

传统Internet通过OSPF、BGP等标准路由协议Underlay传输,它不感知时延、丢包等QoS故障,导致无法满足上层业务应用QoS质量诉求。Internet长距离传输无法满足普通TCP类业务QoS要求,因为跨国端的时延基本大于300ms,丢包率超过20%。

我们针对以上问题自研了全链路网络加速服务,在InternetUnderlay网络上叠加Overlay网络,实时感知每条链路的QoS(时延、丢包率),选择最佳Overlay路径流量转发,从而提供相应的QoS承诺。

基于全链路传输加速服务,应用于国内RTC加速场景,从测量数据上看,ADN选择的路径时延要小于级联架构组网下RTC的时延,在极端情况下对比更明显。部分路径优势非常明显,如郑州到济南,从50ms提升至10ms以内。应用于海外加速效果,时延加速在Internet传输的几百毫秒的基础上平均提升20%,全球时延在200ms以内,消除了90%的丢包场景。

总结与展望

最后,总结下今天分享的内容:

业务策略,建立面向不同媒体业务场景的体验质量体系;

端到端的质量管理过程,体验质量贯穿媒体业务的设计、研发、运维全生命周期;